近日,中国计算机学会(CCF)推荐的A类国际学术会议ACM International Conference on Multimedia(简称ACM MM 2023,ACM国际多媒体会议)论文接收结果公布。会议共收到3000+篇投稿,最终录用902篇,录用率为29.3%。我院智能多媒体安全实验室的论文 “UMMAFormer: A Universal Multimodal-adaptive Transformer Framework For Temporal Forgery Localization” (作者:张瑞,王宏霞,杜明珊,刘汉卿,周炀,曾强)被录用,第一作者为我院博士生张瑞同学,指导老师是王宏霞教授,澳门永利yl6776为论文唯一单位。ACM MM 自1993年首次举办以来,已成为多媒体领域的重要学术盛会,本届会议将在加拿大渥太华举办。

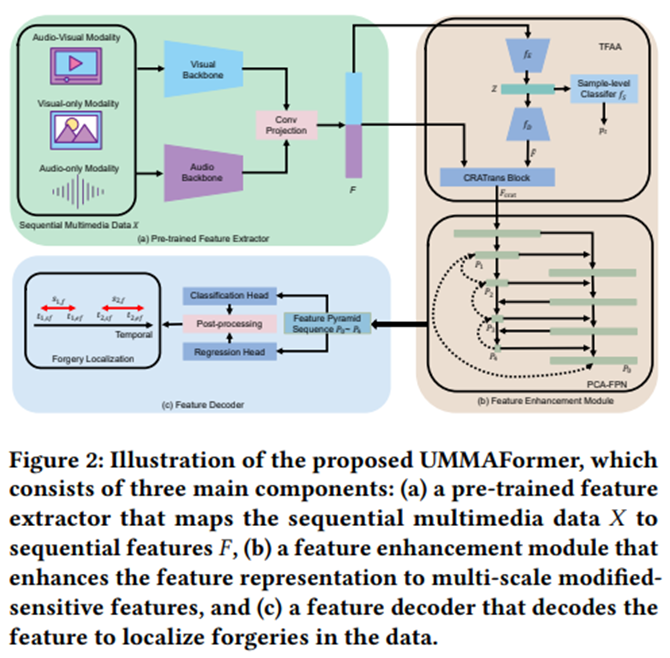

随着人工智能生成技术的不断发展,生成的虚假媒体愈加逼真,使“眼见为实”、“有图有真相”的思维方式受到质疑,因此,多媒体内容的真伪鉴别变得愈加困难。现有的研究通常仅基于二分类器来区分整段多媒体内容的真伪,对于局部伪造内容缺乏有效的检测手段。这篇论文正是针对这一问题提出了一种新颖的通用框架——UMMAFormer。该框架能够适应不同模态多媒体内容,包括音频、视频或者音视频多模态,并从中精准预测伪造片段的开始和结束时间,实现时序局部伪造内容的定位。为了增强对时序异常特征的关注,本文采用了一种创新的时序特征异常注意模块,这使得系统在检测伪造内容时更加准确。此外,针对局部短伪造片段特征的增强,论文还引入了并行交叉注意特征金字塔网络,进一步提升了性能。为了验证所提方法的有效性,还构建了一种专门针对视频涂改场景的时序视频涂改定位数据集。实验结果表明,所提方法在多个基准数据集(如Lav-DF、TVIL、Psynd等)上均取得了最先进的性能。